Saat perusahaan berlomba-lomba mengadopsi chatbot yang digerakkan oleh AI generatif, penting untuk mengurangi risiko terpapar pelaku ancaman yang memaksa model AI untuk membuat konten berbahaya. Google melalui Vertex AI dapat membantu mengelola risiko tersebut. Lalu, bagaimana cara menggunakannya?

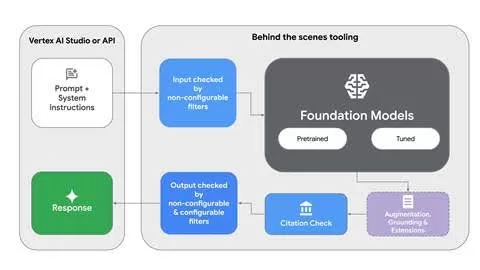

Model Gemini pada Vertex AI menggunakan dua jenis filter konten

Filter keamanan yang tidak dapat dikonfigurasi secara otomatis memblokir keluaran yang berisi konten terlarang, seperti materi pelecehan seksual anak dan informasi identitas pribadi.

Filter konten yang dapat dikonfigurasi memungkinkan Anda menentukan ambang batas pemblokiran dalam empat kategori bahaya (ujaran kebencian, pelecehan, konten seksual eksplisit, dan konten berbahaya) berdasarkan skor probabilitas dan tingkat keparahan. Filter ini dinonaktifkan secara default, tetapi Anda dapat mengonfigurasinya sesuai kebutuhan.

Photo Credit: Google Cloud Blog

Penting untuk dicatat bahwa, seperti sistem otomatis lainnya, filter ini terkadang dapat menghasilkan hasil positif palsu, yang secara keliru menandai konten yang tidak berbahaya. Hal ini dapat berdampak negatif pada pengalaman pengguna, terutama dalam pengaturan percakapan.

System instructions: Pengarahan model proaktif untuk keamanan khusus

Petunjuk sistem untuk model Gemini di Vertex AI memberikan panduan langsung kepada model tentang cara berperilaku dan jenis konten yang akan dibuat. Dengan memberikan petunjuk khusus, Anda dapat secara proaktif mengarahkan model agar tidak membuat konten yang tidak diinginkan untuk memenuhi kebutuhan unik perusahaan.

Baca juga: Gemini Kini Menyediakan Perlindungan Data Tambahan untuk Akun Sekolah

System instructions memiliki keuntungan berikut dibandingkan filter konten:

- Anda dapat menentukan bahaya dan topik tertentu yang ingin dihindari dan tidak terbatas pada sekumpulan kategori kecil.

- Lebih detail. Misalnya, alih-alih hanya mengatakan “hindari ketelanjangan”, Anda dapat menentukan apa yang dimaksud dengan ketelanjangan dalam konteks budaya dan menguraikan pengecualian yang diizinkan.

- Anda dapat mengulangi instruksi untuk memenuhi kebutuhan. Misalnya, jika Anda melihat bahwa instruksi “hindari konten berbahaya” menyebabkan model menjadi terlalu berhati-hati atau menghindari topik yang lebih luas dari yang dimaksudkan, Anda dapat membuat instruksi lebih spesifik, seperti “hindari diskusi tentang penggunaan narkoba ilegal”.

Baca juga: Gemini Kini Tersedia di BigQuery, Bisa Apa Saja?

Namun, system instructions memiliki batasan sebagai berikut:

- Lebih rentan terhadap zero-shot dan teknik jailbreak rumit lainnya.

- Menyebabkan model menjadi terlalu berhati-hati pada topik-topik yang tidak jelas.

- Dalam beberapa situasi, system instruction yang rumit untuk keselamatan dapat secara tidak sengaja memengaruhi kualitas keluaran secara keseluruhan.

Evaluasi konfigurasi keamanan Anda

Photo Credit: Freepik

Anda dapat membuat set evaluasi dan menguji performa model dengan konfigurasi spesifik Anda sebelumnya. Disarankan untuk membuat set yang berbahaya dan tidak berbahaya secara terpisah, sehingga Anda dapat mengukur seberapa efektif konfigurasi Anda dalam menangkap konten yang berbahaya dan seberapa sering konfigurasi tersebut secara tidak tepat memblokir konten yang tidak berbahaya.

Baca juga: Model Gemini 2.0 Kini Tersedia untuk Umum

Fitur Vertex AI berperan dalam memastikan penggunaan Gemini yang aman dan bertanggung jawab. Pendekatan terbaik bergantung pada persyaratan khusus dan toleransi risiko Anda. Untuk memulai, Anda bisa melihat dokumentasi tentang content filters dan system instructions ini.

Kemudahan Vertex AI ini bisa Anda nikmati cukup dengan berlangganan Google Cloud yang kini telah tersedia di EIKON Technology. Untuk informasi lebih lanjut, silakan hubungi kami di sini!